Ayni zamanda board member‘i oldugum DeepCrawl icin guzel bir yazi hazirladim. Yaziyi okumaya baslamadan once eger yillardir Deepcrawl kullaniyorsaniz bu yazi sizin icin basit olabilir. Bu yaziyi Deepcrawl yeni kullanmaya baslayan ya da baska hangi durumlarda nasil kullabilirim diye dusunenler icin yazdim.

Teknik analizleri seviyoruz degil mi? Bulmaca gibi sorunun oldugu noktalari tespit edip cozerek daha sonra da Google’da organik trafigimizi yukseldigini gormek bizi mutlu ediyor olsa gerek. Teknik analizlerimiz icin Deepcrawl olmazsa olmaz bir arac bizim icin. Hem sitemizin teknik kisimlarindaki hatalari detaylica anlamamizi sagliyor hem de analiz ettigimiz yuzbinlerce sayfayi birbiri ile kiyaslayip olasi content sorunlarini daha net gormemizi sagliyor. Henuz Deepcrawl ile tanismadiysaniz sizi boyle alayim, bir goz atin derim.

Bugun sizlere Deepcrawl kullanarak kolaylikla altindan kalkabilecegimiz 14 farkli durumu paylasmaya calisacagim. Eminim bu senaryolarda siz farkli araclar ya da methodlar kullaniyorsunuzdur ama Deepcrawl ile bu senaryolari daha kolay ve hizli cozebilecegimizi bilmenizi isterim. O zaman lafi daha fazla uzatmadan baslayalim mi?

1. Yeni siteye / URL yapisina gecislerinde

En can sikici noktalardan birisi de site gecisleri degil mi? Gecisleri yanlis yonettikleri icin var olan organik trafiklerini kaybeden bir cok marka taniyorum. Sitenizi yeni bir alt yapiya mi tasiyorsunuz? Ya da URL yapinizi mi degisiyorsunuz? O zaman Deepcrawl kullanmanizin tam zamani. Hemen simdi bizi arayin :) (Saka tabi ki Televizyon reklami gibi oldu ama) Peki nasil?

Bunun bir kac yolu var;

- Sitenizdeki eski URL’lerin bir listesini cikartip list crawl secenegi ile bunlari import ederek yeni URL yapisina dogru sekilde yonlenip yonlemediginden emin olabilirsiniz. Ayrica eski sayfalarinizda gecis oncesi duzeltmeniz gereken hatalar/eksiklikler varsa bunlari da tespit etmis olursunuz.

- Eski URL’lerinizin tamami sitemap dosyasinda yer aliyorsa sitemap crawl secenegi ile sitemap dosyalarinizi import edip eski URL’leriniz hakkinda bilgi sahibi olabilirsiniz. Tabi yeni URL’leriniz Google’a kapali sekilde yer aliyorsa advanced settings kismindaki Test Site Basic Authentication ile yayin oncesi kapali beta olarak hatalarinizi gorebilirsiniz. Tum yeni URL’leriniz dogru sekilde 301 yonlendirme yapilmis mi, yeni sayfalarinizda duplicate content ya da 4xx hatasi veren sayfalar neler gibi kritik tum sorunlari yayina almadan once cozebilirsiniz.

- Tabi unutmadan en cok organik trafik alan sayfalarinizi mutlaka Google Analytics ya da kullandiginiz diger analytics aracindan export edip ayrica Google search console’dan da en cok impression ve click alan sayfalari da export ederek bu listeyi Deepcrawl’a “list crawl” secenegiyle yukleyerek gecis oncesi ya da gecis sonrasi sayfalarinizdaki hatalari gorerek duzeltebilirsiniz.

Ayrica advanced settings kismindaki “Test Site Domain” kismina yeni sitenizin erisim bilgilerini yazarak eski siteniz ile yeni sitenizi kiyaslayarak yayina acmadan once hatalari daha net gorebilirsiniz.

2. Organik trafigimizin dustugu zamanlar

Bazen anlamsiz bir sekilde organik trafigimiz dusmeye baslar ne yaptiysak bunu duzeltemeyebiliriz. Google’in manuel action cezasi, algoritmaya takilma ya da spam link building calismalari disinda bunu anlamamiz daha kolay. Sezonsal bu degisimlerin disinda eger sitemizdeki teknik eksikliklerden kaynakli oluyorsa bunu tespit edip hatayi duzeltmemiz Deepcrawl ile cok kolay.

Peki, nasil yapabiliriz?

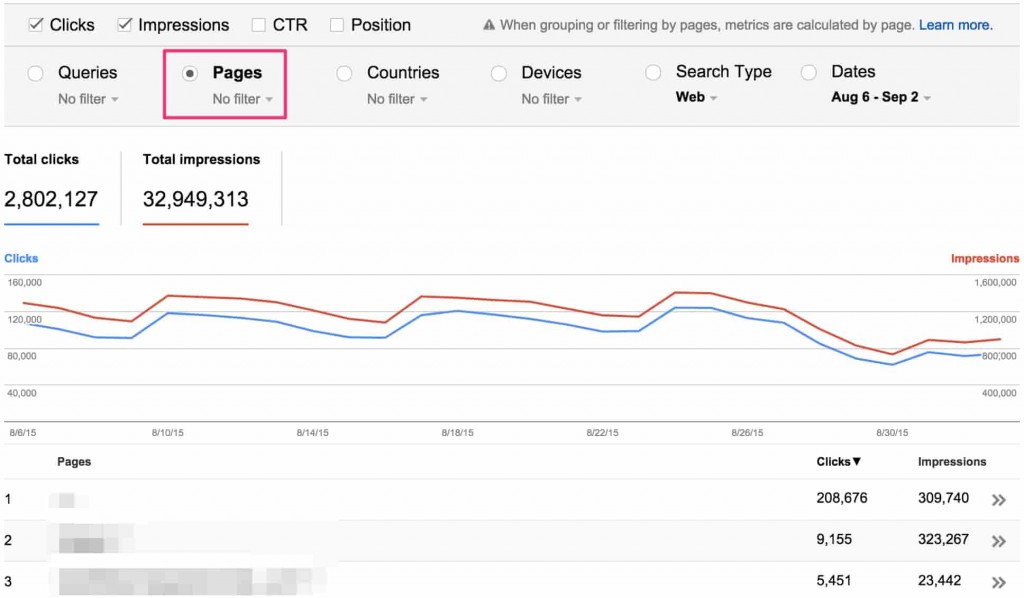

Google Analytics ya da kullandiginiz analytics aracindan en cok trafik alan sayfalarin dusus baslamadan onceki tarihlerini secip export edip Deepcrawl’a “list crawl” secenegiyle yukleyerek bu sayfalarda fark etmedigimiz bir degisiklik olmus mu inceleyebiliriz. Ayrica trafiklerin dusmeye basladigi tarihten sonra hangi sayfalarin trafikleri daha cok dustuyse bunlari da Google Analytics’ten kiyaslayip export ederek Deepcrawl ile ozel olarak inceleyebiliriz.

Benzer sekilde Google search console’dan da en fazla click ve impression alan sayfalari dususten once ve sonra olacak sekilde export edip incelemeliyiz. Neden sadece Google Analytics ile yetinmiyoruz? Cunku search console datalari bazen Google Analytics datalarindan daha fazla hayat kurtarici olabiliyor.

Son olarak en fazla backlink alan sayfalarimizi da majestic, ahrefs gibi backlink kaynaklarindan export edip teknik olarak olaganustu bir degisim olmus mu diye kontrol edebiliriz. Bir musterimin basina gelmisti en fazla backlink aldigi sayfalardan bir cogu farkinda olmadan 404 hatasi donmeye baslamisti ve bir sure sonra aranma hacmi yuksek kelimelerde pozisyon kaybettikleri icin organik trafikleri dusmeye baslamisti.

3. Mobil siteyi / arayuzu yayina almadan once

Google’in nisan ayinda yaptigi aciklama ile mobil sitesi / arayuzu olmayan sitelerin mobil siralamalarda pozisyon kaybedebilecegini soylemisti. Gecisten sonra hangi sitelerin mobil sonuclarda pozisyonu yukseldi hangilerinin dustu anlamak adina Searchmetrics guzel bir analiz yayinlamisti.

Durum bu kadar ciddi boyutlardayken mobil arayuzumuzu yayina almadan once her seyin sorunsuz oldugundan emin olmaliyiz. Iste tam bu noktada Deepcrawl yardimimiza kosuyor. Mobil arayuzumuzu yayina almadan once disariya kapali iken Deepcrawl ile sitemizi tarayabilecegimizi ogrenmistik. Advanced Settings kismindan user-agent Google’in mobil agent’ini sectigimizde sitemizi tarayip olasi hatalari yayina almadan once ogrenebiliriz. Mesela en onemli sayfalarinizdan birinin mobil user-agent’a 404 dondugunu test etmeden nasil bilebilirdiniz? Ya da mobil user-agent ile sitemize gelen botlara sitemizin web versiyonu olan canonical degerini verip vermedigimizden nasil emin olabilirdik? Iste tum bu sorulari mobil arayuzu yayina almadan cevaplamis oluyoruz. Guzel degil mi? :)

Bir diger nokta eger mobil arayuzunuz varsa genel bir tarama yapmak istiyorsaniz yine search console altindan “search analytics” kismindan device olarak mobil secip en cok trafik alan mobil sayfalarinizda olasi hatalari varsa duzeltebilirsiniz.

4. Rakiplerin pozisyon kazandigi kelimelerde bizim sayfalarimizin durumunu analiz etmek icin

Deepcrawl’u kullanirken en sevdigim analizlerden birisi de bu. Belirli kelimelerde rakiplerin pozisyon kazandigi sayfalari export edip bunlari analiz ederek arti yonlerini anlamaya calismak. Bunun icin bir cok arac olmakla birlikte ben link research tool’un “SERP Research Tool” aracini kullaniyorum. Benzer sekilde search metrics ve semrush gibi araclari da kullanarak bu sayfalari tespit edebilirsiniz.

Belirli kelimelerde rakiplerin sayfalarini analiz edip neleri farkli yaptiklarini, eksi yonlerini kolayca anlayabiliyorum. Tabi bu analize link metriclerini ve social paylasim datalarini da ekleyerek analizinizi bir adim ileri goturebilirsiniz. Neyse bu rakip datalarini inceleyip title, description sayfadaki metin orani vb bir cok metrigi analiz edebiliyoruz. Bu insigth ile SEO calismalarimiza bir yenisini eklemis oluyoruz.

5. Sitemap dosyalarinizda olmayan URL’lerin tespiti

Bildigimiz uzere sitemap dosyalari arama motorlarinin sitemizi kolay crawl etmesini saglayan onemli dosyalardir. Peki sitemap dosyamizda olmayan sayfalari tespit edip sitemap’e eklemeye ne dersiniz? Bu sayede arama motorlari bu sayfalariniza daha kolay ulasacaktir ve kimi zaman daha hizli crawl edecektir. Bunu Deepcrawl ile yapmak icin tarama baslatirken “universal” secenegini secip sitemap dosyanizi gostermeniz yeterlidir. Analiz sonrasinda rapor sekmesinde “universal” sekmesini goreceksiniz. Burada sitemap dosyalarinizda olmayan URL’leri export edip kolaylikla ekleyebilirsiniz. Bu sayede olasi crawl rate dususleriniz varsa bu sizin isinizi kolaylastiracaktir.

6. Sitemap dosyanizda farkli URL’e yonlenen URL’lerin tespiti

Arama motorlarinin sitenizi taramak icin ayirdiklari kaynak sinirli. Durum boyleyken bu kaynagi duzgun kullanirsak rakiplere karsi avantaj elde etmis oluruz. Bunlardan birisi de yonlendirdigimiz URL’ler. Eger yonlendirdigimiz URL’ler uzerinden aylar gecmesine ragmen halen sitemap dosyalarimizda eski yonlenen URL’leri barindiriyorsak bu SEO performansimizi negatif etkileyen bir durum. Deepcrawl sayesinde sitemap dosyalarimizda yonlenen URL’leri tespit edip bunlari yonlendigi sayfayi sitemap’e ekleyecek sekilde duzenleyebiliriz. Bunun icin Deepcrawl proje baslatirken “universal” crawl secenegini secip sitemap dosyalarinizi gostererek tarama bittiginde de “universal” sekmesi altindan “Redirecting sitemap URLs” kismindan bu URL’leri ogrenebiliriz.

7. Duplicate sayfalarin / iceriklerin tespitinde

Optimize ettiginiz sitenizin binlerce sayfasi varsa duplicate content basli basina bir bela oluyor hepimiz icin. Yuzbinlerce sayfadan hangi sayfalarin icerikleri birbiriyle benzerlik gosteriyor bunu tespit etmemiz manuel olarak cok zor, neredeyse imkansiz. Deepcrawl’un gelismis duplicate content algoritmasi sayesinde arama motorlarinin nefret ettigi duplicate content konusundan tamamen kurtulabilirsiniz. Projenizi baslatmadan once “Report Settings” kismindan “Duplicate Precision” bolumunden benzerlik oranini da kendiniz ayarlayabilirsiniz. Bu sayede cok daha hassas analizler yaparak olasi duplicate content sorunlarinin onune gecmis olursunuz. Bu raporlara Deepcrawl altindan su sekilde erisebilirsiniz.

Indexable Pages sekmesinden Duplicate Pages bolumunden

Content sekmesinden Duplicate Body Content bolumunden

8. Uzun sayfa basliklarini pixel ile kontrol etme

Sayfa title ve description metalarinin belirli bir karakterde olmasi gerektigini hepimiz biliyoruz artik ama bazen bu karakter engeliyle birlikte pixel kontrolunu de yapmamiz gerekiyor. Zira yoksa arama sonuclarinda belirli bir kelimeden / pixelden sonrasi icin Google ( … ) koyarak olayin tum heyecanini kacirabiliyor.

![]()

Heyecanimiz kacmasin, arama yapanlar nerede bu cumlenin sonu demesin diye hem kelime hem de pixel kontrolu yaparak bu uzunlugu arama motorlarinin istedigi boyutta tutabiliriz. Ayni zamanda bu analizi mobil user-agent secerekte yapabiliriz. Bu sayede mobil sonuclarda pixel sinirini gecen sayfalarimizi kolayca tespit edip duzenleyebiliriz.

9. Az icerik bulunan sayfalar

Urettigimiz iceriklerin arama sonuclarinda pozisyon kazanmasi icin belirli bir uzunlukta olmasi gerekiyor. 1 paragraf yazip yayina aldigimiz sayfalarin rekabetin yuksek oldugu kelimelerde ilk sayfada yer almasini bekleyemez degil mi?

SERPIQ’nun daha once yaptigi bir analizde belirli bir kelime sayisinin uzerinde olan sayfalarin pozisyon kazanmasinin daha kolay oldugunu ortaya koydu.

Deepcrawl, taratilan sayfalari analiz edip icerik oranini hesaplayarak belirli kelime altinda olan sayfalari sizinle paylasiyor. Bu sayede eger bu sayfalarin ilk sayfada pozisyon kazanmasini istiyorsaniz (hangimiz istemeyiz degil mi?) iceriklerin uzunlugunu arttirmamiz gerekiyor. Kimi zaman bu sayfalar bir urun aciklama sayfalari, kategori sayfalari ya da blogumuz icin yazdigimiz bir sayfa olabilir. Bu gelistirmeleri yaptiktan sonra bu sayfalarin yavas yavas ilk sayfaya dogru pozisyon kazandigini goreceksiniz. Rapora validation sekmesi altindan Min Content/HTML Ratio bolumunden ulasabilirsiniz.

10. Sitenizdeki link cikislarini takip edin

Yuzbinlerce sayfaniz varsa ve icerigin buyuk bir kismini editorler olusturuyorsa siz farkinda olmasanizda bir cok siteye link veriyor olabilirsiniz. Tabi ki baska sitelere link vermek faydali bir sey ancak sitenizden 1000 nofollow olmayan link cikisi oldugunu dusundugunuzde bu biraz can sikici ve SEO performansinizi negatif etkileyen bir etken olarak karsiniza cikacaktir. Peki hangi sayfalardan farkli sitelere link cikisi var diye merak ediyor olabilirsiniz. Ben genelde hep merak ediyorum ve kesin analiz yaptigim sitelerde buna denk geliyorum.

Daha once danismanlik verdigim sirketlerden birinde denk geldim. Siteye uye olan herkesin profil sayfasina kendi sitesini ekleme sansi tanimislardi. Site Google degerleri yuksek site oldugu icin herkes bu siteden link elde etmenin yollarini ariyordu. Analizlerde ozel SEO yazilimlarinin bu site icin otomatik profil sayfalari olusturdugunu ve link cikislari verdigini fark ettik. Bu sekilde milyonlarca sayfa olusturmuslar. Ustelik bu linklerin hicbiri nofollow degil. Hayal edebildiniz mi? Deepcrawl ile analiz sonrasinda bu sayfalari tespit edip tum linkleri kaldirarak SEO performansinin dusmesini engellemistik.

Ben bunu nereden ogrenebilirim?

Deepcrawl tarama islemi bittiginde raporlarda “validation” kismi altinda “All External Links” kismindaki linkleri inceleyerek kendi siteniz icin link cikisi verdigini sayfalari ve hangi sayfalara/sitelere link cikisi verdiginizi gorebilirsiniz.

11. Canonical olmayan sayfalarin tespiti

Biz SEO’larin kontrol etmesi gereken ne cok sey var degil mi? :) Buyuk ya da kucuk fark etmez optimize etmeye calistiginiz bir sitenin eger canonical olmayan sayfalari varsa bunlar duplicate content olusturma riski cok yuksektir. Sizin haberiniz olmadan herhangi bir siteden sizin bu canonical olmayan sayfalariniza verilen parametreli linkler arama motorlari tarafindan indexlenmesine ve parametresiz sayfaniz ile duplicate olmasina neden olacaktir. Ne diyorsun ilyas bir ornek ver diyenler icin. Soyle bir sayfamiz olsun; www.example.com/product-a/ eger bu sayfamizda canonical metasi yoksa asagidaki sekilde

www.example.com/product-a/?utm_source=google&utm_medium=text&utm_campaign=product

farkli bir siteden backlink gelirse bize arama motorlari bu URL’i de takip edip sayfayi crawl edecegi icin farkli bir sayfaymis gibi algilayip yeniden indexleyebilir. Bu da bizim icin duplicate content demek ve SEO performansimizi negatif etkileyen bir etken.

Ornek bakacak olursak saka degil Google’da bu sekilde indexlenmis 96 binden fazla sayfa var. Bir cogu da duplicate ustelik. Cunku bu sayfalarda canonical metasi yok.

Lafi bayagi uzattim ama onemini anlamak icin guzel oldu. Iste tam bu kadar kritik bir durumda Deepcrawl ile sitemizi tarattigimizda hangi sayfalarimizda canonical olmadigini tespit edip bunlari duzeltmemizde bize fayda sagliyor.

12. Tutarsiz hreflang etiketlerinin tespitinde // Inconsistent hreflang Tags

40 farkli ulkede SEO calismalari yurutuyorsaniz hreflang etiketinin ne kadar onemli oldugunu sizden iyi bilen yoktur eminim. Arama motorlarina farkli dildeki sayfalarinizi ifade ettiginiz bu etiketin sayfalarinizda yanlis ya da tutarsiz bir sekilde eklendigini dusundugunuzde zarariniz tahmin ettiginizden fazla olabiliyor. Ozellikle yuksek aranma hacmi ve rekabetin yuksek oldugu kelimelerde hedeflediginiz sayfalar icin.

Iste tam bu noktada Deepcrawl imdadimiza yetisiyor ve tutarsiz hreflang etiketlerini tespit etmemizi sagliyor. Sitemizi crawl ettigimizde eger tutarsiz hreflang etiketleri varsa bu rapora Validation sekmesinden Inconsistent hreflang Tags basligi altindan ulasabilirsiniz. Yapmaniz gereken herhangi bir sayfanin Turkce versiyonu varsa onu ilgili sayfadan belirtmek ve ayni sekilde Turkce sayfadan da ingilizce versiyonunu hreflang ile belirtmek. Tek tarafli belirttiginizde maalesef tutarsiz hreflang entegrasyonu yapmis oluyorsunuz ve bu arama motorlari icin sorun teskil ediyor.

13. Cok gec yuklenen sayfalarin tespiti

Hepimizin bildigi uzere 2010 yilinda Google’in resmi blogunda yaptigi aciklama ile site ve sayfa yuklenme hizinin siralamaya direkt etki ettigini duyurmustu.

5 yil once yapilan bu aciklamadan sonra Google ciddi anlamda yavas yuklenen sitelere karsi savas acmis durumda. Yakinda zamanda yavas yuklenen sitelerin yaninda slow iconu ile testler yaptigini gormustuk. Kullanicilarin siteye tiklamalarina buyuk oranda etki edecek bu icon ile aslinda Google sitenizin hizi kullanici deneyimini azaltacak kadar dusuk, hizlandirma zamanin geldi diyor.

Binlerce sayfamiz icerisinden hangileri yavas yukleniyor datasini alabilecegimiz en saglikli yollardan birisi de Deepcrawl. Yaptigimiz tarama sonucunda Deepcrawl yavas yuklenen sayfalari filtreleyip bize sunuyor ve biz de bu sayfalarimizi optimize etmeye basliyoruz. Rapora validation sekmesi altindan Max Load Time kismindan ulasabilirsiniz.

Peki bu sayfalarimizi nasil hizlandirabiliriz? Yapabilecegimiz ve kullanabilecegimiz onlarca tool var benim onerdiklerim ise; Google page speed, gtmetrix, pingdom page speed

Konu hizdan acilmisken yapilan bir testte site yuklenme hizinin donusum oranlarina nasil etki ettigini gosteriyor. Durum dusundugumuzden daha ciddi degil mi?

14. Sosyal medyadan neden trafik alamiyorum?

Hepimiz artik sosyal medya’dayiz. Mutlaka gunde 1 kez Facebook, Twitter hesaplarimizi kontrol ediyoruz. Ne olmus ne bitmis diye. Artik yogun bir sekilde kullanilan bu Sosyal networklerden daha fazla trafigi sitemize yonlendirmemiz mumkun. emarketer datalarina gore 2017’de dunyada sosyal medya kullanan kisi sayisi 2.3 milyar civari olacak goruluyor. Bir hayli fazla degil mi?

Peki bizim sitemiz, sayfalarimiz sosyal aglarda nasil gorunuyor? Kullanicilar herhangi bir sayfamizi sosyal aglarda paylastiginda istedigimiz sekilde mi gorunuyor? Ozellikle Facebook ve Twitter trafik alabilecegimiz en buyuk siteler. Peki sayfalarimiz bu siteler icin tamamen optimize olmus mu sizce? Deepcrawl ile bunu anlamamiz cok kolay. Tarattigimiz 100 binden fazla sayfada eksik olan Facebook ve Twitter tag’larini tek tek bize sunup olasi hatalari duzelterek kullanicilarin sayfalarimizdaki gorselleri, basliklari ve aciklama kisimlarini istedigimiz sekilde gormelerini saglayabiliriz. Bu sayede daha fazla CTR almamiz elimizde. Peki bu rapora nereden ulasabiliriz? Content sekmesi altindan Social Tagging bolumunde eksik tag olan sayfalarimizi tespit edebiliriz.

BONUS

Google’in fetch as Google aracini kullanmayanimiz yoktur. Henuz tanismayanlar varsa buradan bilgi edinebilirler

https://support.google.com/webmasters/answer/6066468?hl=en

Bazen herhangi bir sayfamizi farkli user-agent ile farkli ulke IP’leri ile test edip nasil sonuc geldigini gormek isteyebiliriz. Bu noktada Deepcrawl ile bunu kolayca cozebiliriz. Applebot’ta dahil bir cok user-agent ve US, UK, FR gibi bir cok farkli ulke IP’si ile test ettiginiz sayfanin arama motorlari tarafindan nasil gorundugunu kolayca gorebilirsiniz. Unutmadan sayfanizin hangi HTTP kodunu dondugunu ve indexlenebilir olup olmadigini da kolayca gorebiliyorsunuz.

Nereden erisebiliyoruz bu araca derseniz? Buyrun (login gerektirir) https://tools.deepcrawl.co.uk/fetch-as-deepcrawl/

Yazida anlasilmayan yerler olursa yorum olarak paylasabilirsiniz. Siz bu senaryolarin disinda hangi durumlarda Deepcrawl kullaniyorsunuz?

Farkli sorulariniz varsa bana Twitter’dan da ulasabilirsiniz. Twitter: ilyasteker

Cidden yazılarınızı severek okuyor ve takip ediyorum :). Ayrıca deepcrawl’ı detaylıca anlamamızı sağladığınız için de çok teşekkür ederim :).

Digital Age dergisindeki yazıda isminizi gördüm ve sitenize eriştim. Derya deniz bir siteniz var. Çok teşekkür ederim bu kadar bilgiyi ücretsiz sunduğunuz için. Sizin gibi üstatlarımız sayesinde güvenli şekilde yolumuzda ilerleyebiliyoruz. İyi çalışmalar

Hacı siteni yeni buldum güzelmiş şu deepcrawl işini çözdüm sayende eyvallah :)

Yurtdışında gösterdiğin başarıdan dolayı seni kutluyorum fakat “hayırlı bir vatansever” olabilir ve bizi daha çok bilgilendirmelisin. :) yazılarının devamını bekliyoruz.

Seo sorunu hakkında paylaştıklarınızı okudum ve çok beğendim. Arama motoru optimizasyonu yani seo gittikçe önemli bir hale geldi. Teşekkür ederim, başarılarınızın devamını dilerim

Merhaba, yaygın SEO sorunlarına cevap verdiğiniz için çok teşekkür ederim. Seo araçlarını teker teker öğreniyorum. Deepcrawl’da iken sıra sitenize eriştim. Çok teşekkürler.

Facebookta arkadaşım olduğunuz için yazıları daha önce görüp takip ediyorum başarılısınız.

yazılarınıza denk geldim ama çok başarılı bir çalışma tebrik ederim

Çok başarılı bir makale. Deepcrawlı yeni yeni kullanmaya başladım. Sayenizde bir şey öğrendim.

Gayet faydalı bir yazı, çok teşekkür ederim. iyi çalışmalar

İlyas bilgiler için teşekkür ederim, ince ve kendi kullanımından örnekler verdiğin için öğretici olmuş bende test edeceğim deepcrawl bir projemde umarım derdime çare olur.

Evet Bunlardan birine tıkladığınızda, o öğeye odaklanacak ve benzer veya kullanıcılar arasında gezinti yapmanıza olanak tanıyan bir başka seti ortaya çıkacak.

Deepcrawl ile ilgili çok güzel bir içerik. Faydalandım. Teşekkür ederim.